使用C#构建一个同时问多个LLM并总结的小工具

笔记哥 /

05-08 /

49点赞 /

0评论 /

265阅读

## 前言

在AI编程时代,如果自己能够知道一些可行的解决方案,那么描述清楚交给AI,可以有很大的帮助。

但是我们往往不知道真正可行的解决方案是什么?

我自己有过这样的经历,遇到一个需求,我不知道有哪些解决方案,就去问AI,然后AI输出一大堆东西,我一个个去试,然后再换个AI问,又提出了不同的解决方案。

在换AI问与一个个试的过程中好像浪费了很多时间。

突然出现了一个想法,不是可以一下子把问题丢给多个AI,然后再总结一下出现最多的三个方案。那么这三个方案可行的概率会大一点。然后再丢给Cursor或者Cline等AI编程工具帮我们实现一下。

这样做的缺点是比起直接在网页上问,调用API需要耗费Token,但是硅基流动给我赠送了很多额度还没用完,随便玩一下。

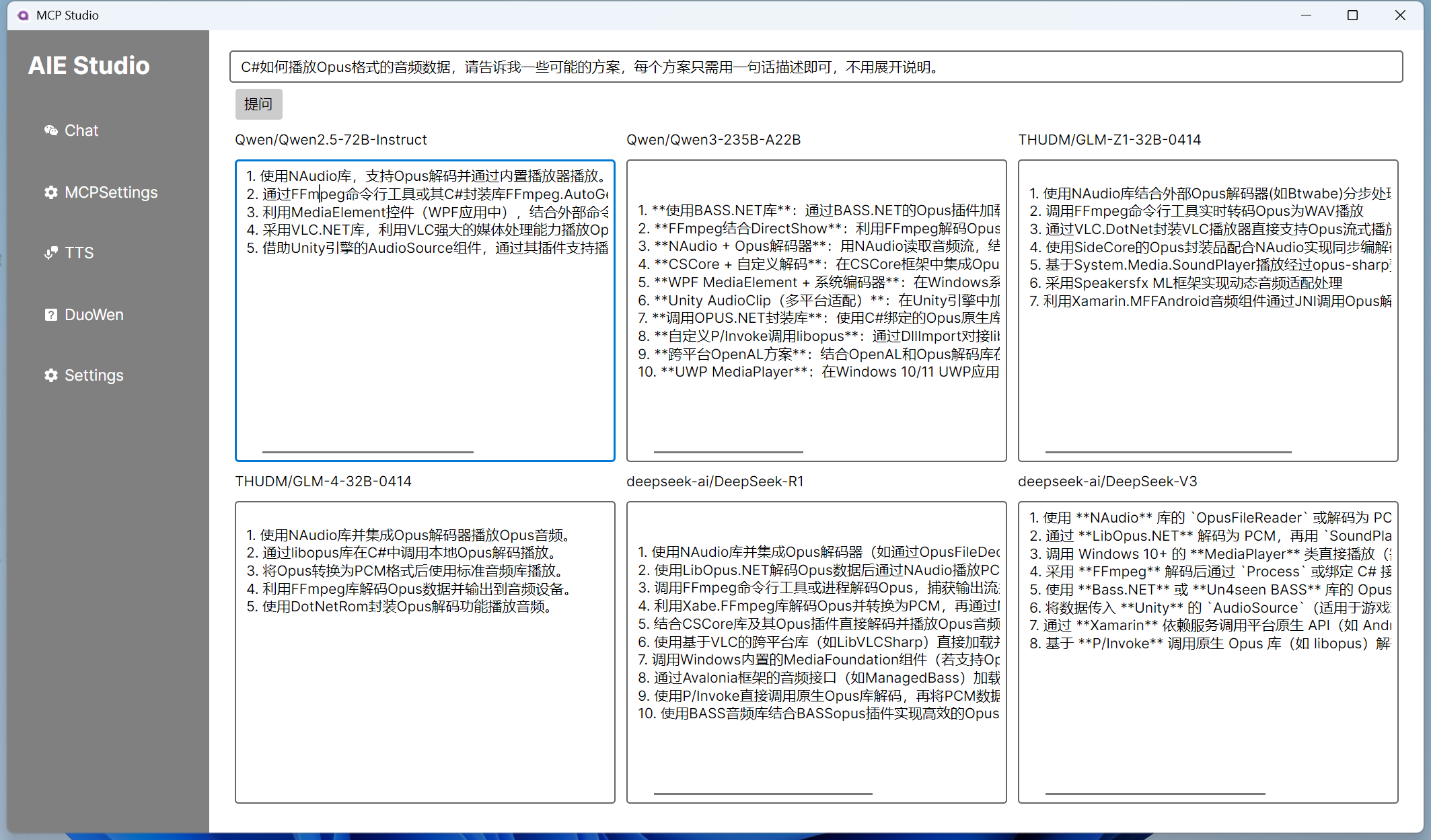

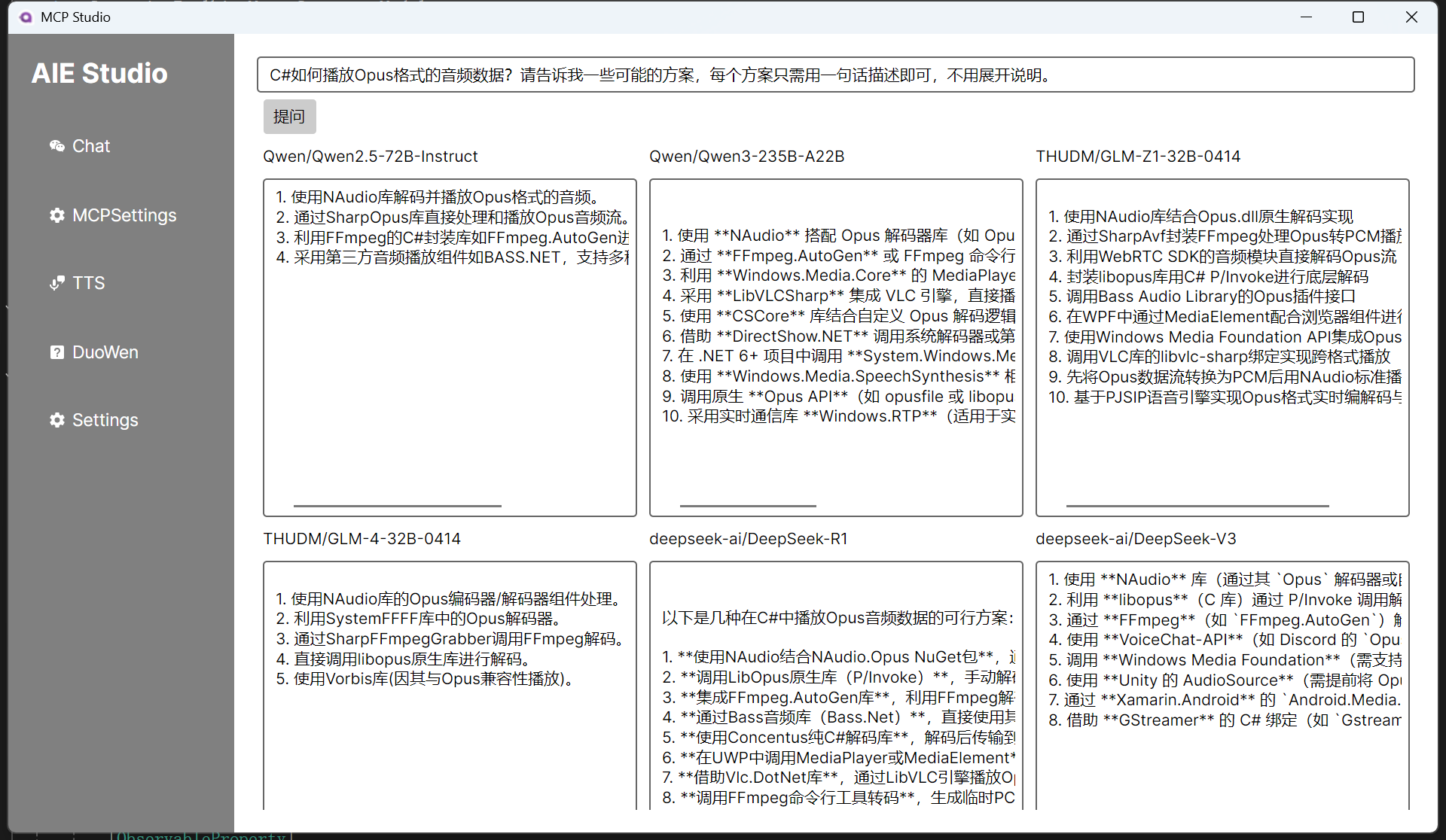

实现效果:

## 实现方案

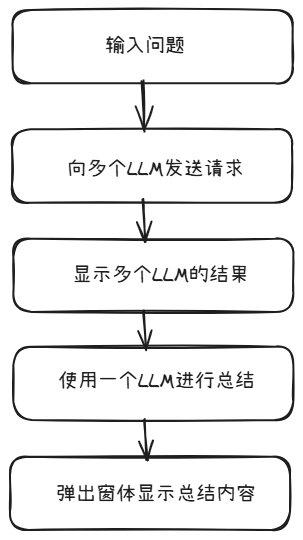

实现方案也很简单,如下图所示:

先设计一下布局:

```xaml

messages = new List();

string prompt = $"""

请分析以下各个助手给出的方案,选择其中提到最多的3种方案。

助手1:{result1}

助手2:{result2}

助手3:{result3}

助手4:{result4}

助手5:{result5}

助手6:{result6}

""";

messages.Add(new Microsoft.Extensions.AI.ChatMessage(ChatRole.User, prompt));

var result7 = await client7.GetResponseAsync(messages);

var showWindow = _serviceProvider.GetRequiredService();

var showWindowViewModel = _serviceProvider.GetRequiredService();

showWindowViewModel.ReceivedValue = result7.ToString();

showWindow.DataContext = showWindowViewModel;

showWindow.Show();

```

以上就成功实现了。

但是还是有可以改进的地方,首先是并行,一个一个问不如同时问。

```csharp

[RelayCommand]

private async Task DuoWenParallel()

{

ApiKeyCredential apiKeyCredential = new ApiKeyCredential("your api key");

OpenAIClientOptions openAIClientOptions = new OpenAIClientOptions();

openAIClientOptions.Endpoint = new Uri("https://api.siliconflow.cn/v1");

// 创建一个列表来存储所有的任务

var tasks = new List>();

// 向每个助手发送请求并将任务添加到列表中

tasks.Add(GetResponseFromClient("Qwen/Qwen2.5-72B-Instruct", apiKeyCredential, openAIClientOptions));

tasks.Add(GetResponseFromClient("Qwen/Qwen3-235B-A22B", apiKeyCredential, openAIClientOptions));

tasks.Add(GetResponseFromClient("THUDM/GLM-Z1-32B-0414", apiKeyCredential, openAIClientOptions));

tasks.Add(GetResponseFromClient("THUDM/GLM-4-32B-0414", apiKeyCredential, openAIClientOptions));

tasks.Add(GetResponseFromClient("deepseek-ai/DeepSeek-R1", apiKeyCredential, openAIClientOptions));

tasks.Add(GetResponseFromClient("deepseek-ai/DeepSeek-V3", apiKeyCredential, openAIClientOptions));

// 等待所有任务完成

var results = await Task.WhenAll(tasks);

// 将结果分配给相应的属性

Result1 = results[0];

Result2 = results[1];

Result3 = results[2];

Result4 = results[3];

Result5 = results[4];

Result6 = results[5];

}

private async Task GetResponseFromClient(string model, ApiKeyCredential apiKeyCredential, OpenAIClientOptions options)

{

IChatClient client = new OpenAI.Chat.ChatClient(model, apiKeyCredential, options).AsChatClient();

var result = await client.GetResponseAsync(Question);

return result.ToString();

}

```

现在虽然是并行了,但是只有等到所有助手都回答了之后,才会统一显示,用户体验也不好。

改成流式:

```csharp

[RelayCommand]

private async Task DuoWenStreaming()

{

ApiKeyCredential apiKeyCredential = new ApiKeyCredential("your api key");

OpenAIClientOptions openAIClientOptions = new OpenAIClientOptions();

openAIClientOptions.Endpoint = new Uri("https://api.siliconflow.cn/v1");

//string question = "C#如何获取鼠标滑动选中的值?请告诉我一些可能的方案,每个方案只需用一句话描述即可,不用展开说明。";

IChatClient client1 =

new OpenAI.Chat.ChatClient("Qwen/Qwen2.5-72B-Instruct", apiKeyCredential, openAIClientOptions).AsChatClient();

await foreach (var item in client1.GetStreamingResponseAsync(Question))

{

Result1 += item.ToString();

}

}

```

现在查看效果:

最后再改造成流式+并行就好了。

```csharp

[RelayCommand]

private async Task DuoWenStreamingParallel()

{

ApiKeyCredential apiKeyCredential = new ApiKeyCredential("your api key");

OpenAIClientOptions openAIClientOptions = new OpenAIClientOptions();

openAIClientOptions.Endpoint = new Uri("https://api.siliconflow.cn/v1");

// Clear previous results

Result1 = Result2 = Result3 = Result4 = Result5 = Result6 = string.Empty;

// Create a list of tasks for parallel processing

var tasks = new List

{

ProcessStreamingResponse("Qwen/Qwen2.5-72B-Instruct", apiKeyCredential, openAIClientOptions, (text) => Result1 += text),

ProcessStreamingResponse("Qwen/Qwen3-235B-A22B", apiKeyCredential, openAIClientOptions, (text) => Result2 += text),

ProcessStreamingResponse("THUDM/GLM-Z1-32B-0414", apiKeyCredential, openAIClientOptions, (text) => Result3 += text),

ProcessStreamingResponse("THUDM/GLM-4-32B-0414", apiKeyCredential, openAIClientOptions, (text) => Result4 += text),

ProcessStreamingResponse("deepseek-ai/DeepSeek-R1", apiKeyCredential, openAIClientOptions, (text) => Result5 += text),

ProcessStreamingResponse("deepseek-ai/DeepSeek-V3", apiKeyCredential, openAIClientOptions, (text) => Result6 += text)

};

// Wait for all streaming responses to complete

await Task.WhenAll(tasks);

IChatClient client7 =

new OpenAI.Chat.ChatClient("Qwen/Qwen2.5-72B-Instruct", apiKeyCredential, openAIClientOptions).AsChatClient();

List messages = new List();

string prompt = $"""

请分析以下各个助手给出的方案,选择其中提到最多的3种方案。

助手1:{Result1}

助手2:{Result2}

助手3:{Result3}

助手4:{Result4}

助手5:{Result5}

助手6:{Result6}

""";

messages.Add(new Microsoft.Extensions.AI.ChatMessage(ChatRole.User, prompt));

var result7 = await client7.GetResponseAsync(messages);

var showWindow = _serviceProvider.GetRequiredService();

var showWindowViewModel = _serviceProvider.GetRequiredService();

showWindowViewModel.ReceivedValue = result7.ToString();

showWindow.DataContext = showWindowViewModel;

showWindow.Show();

}

private async Task ProcessStreamingResponse(string model, ApiKeyCredential apiKeyCredential, OpenAIClientOptions options, Action updateResult)

{

IChatClient client = new OpenAI.Chat.ChatClient(model, apiKeyCredential, options).AsChatClient();

await foreach (var item in client.GetStreamingResponseAsync(Question))

{

updateResult(item.ToString());

}

}

```

这里使用了一个带有一个参数的委托来更新每个助手回复的结果。

现在再查看效果:

Qwen/Qwen3-235B-A22B、THUDM/GLM-Z1-32B-0414、deepseek-ai/DeepSeek-R1有思考过程,返回结果比较慢。

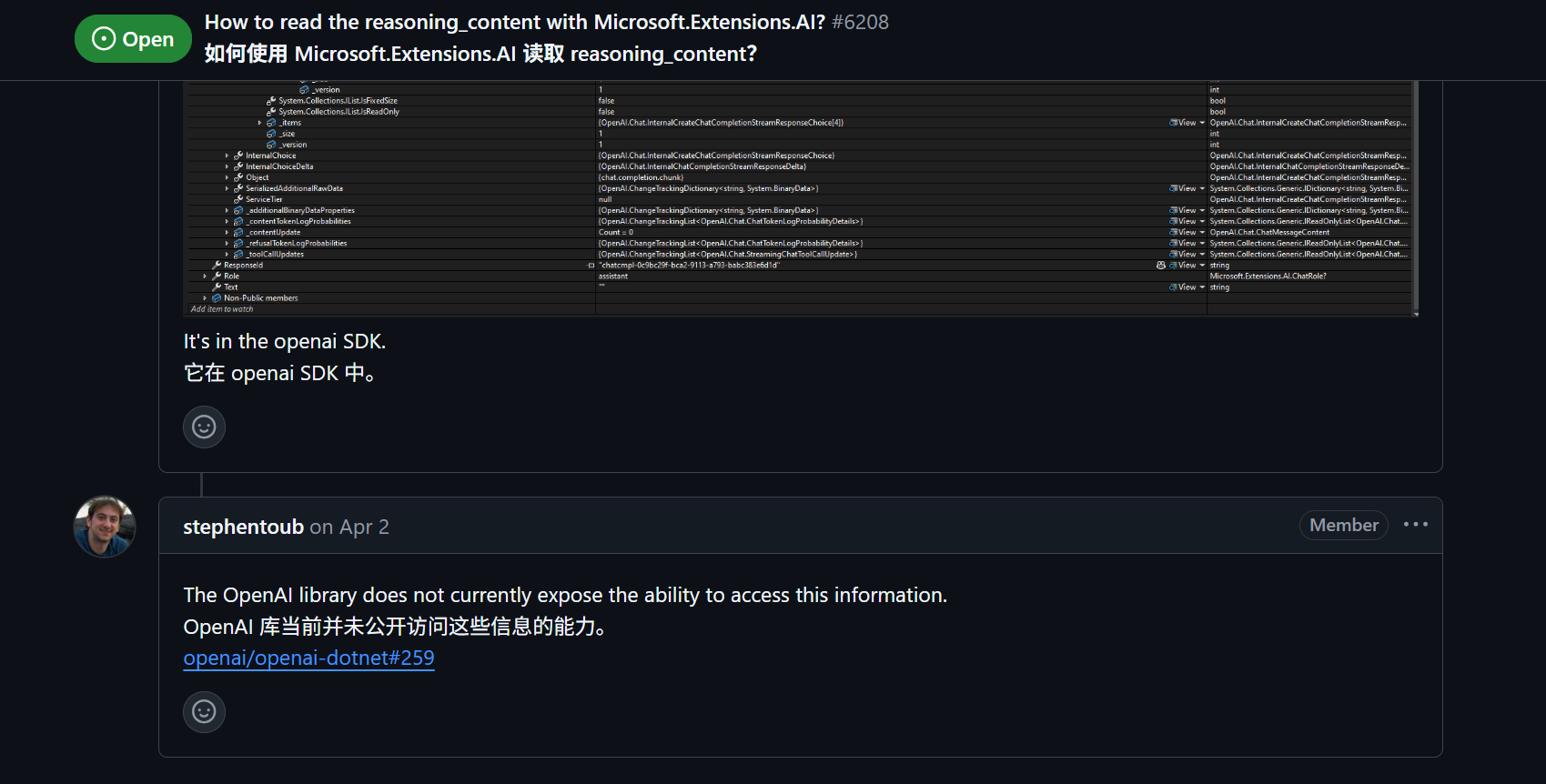

目前Microsoft.Extensions.AI.OpenAI好像还无法获取思考内容。

等待久一会之后,可以看到结果都出来了:

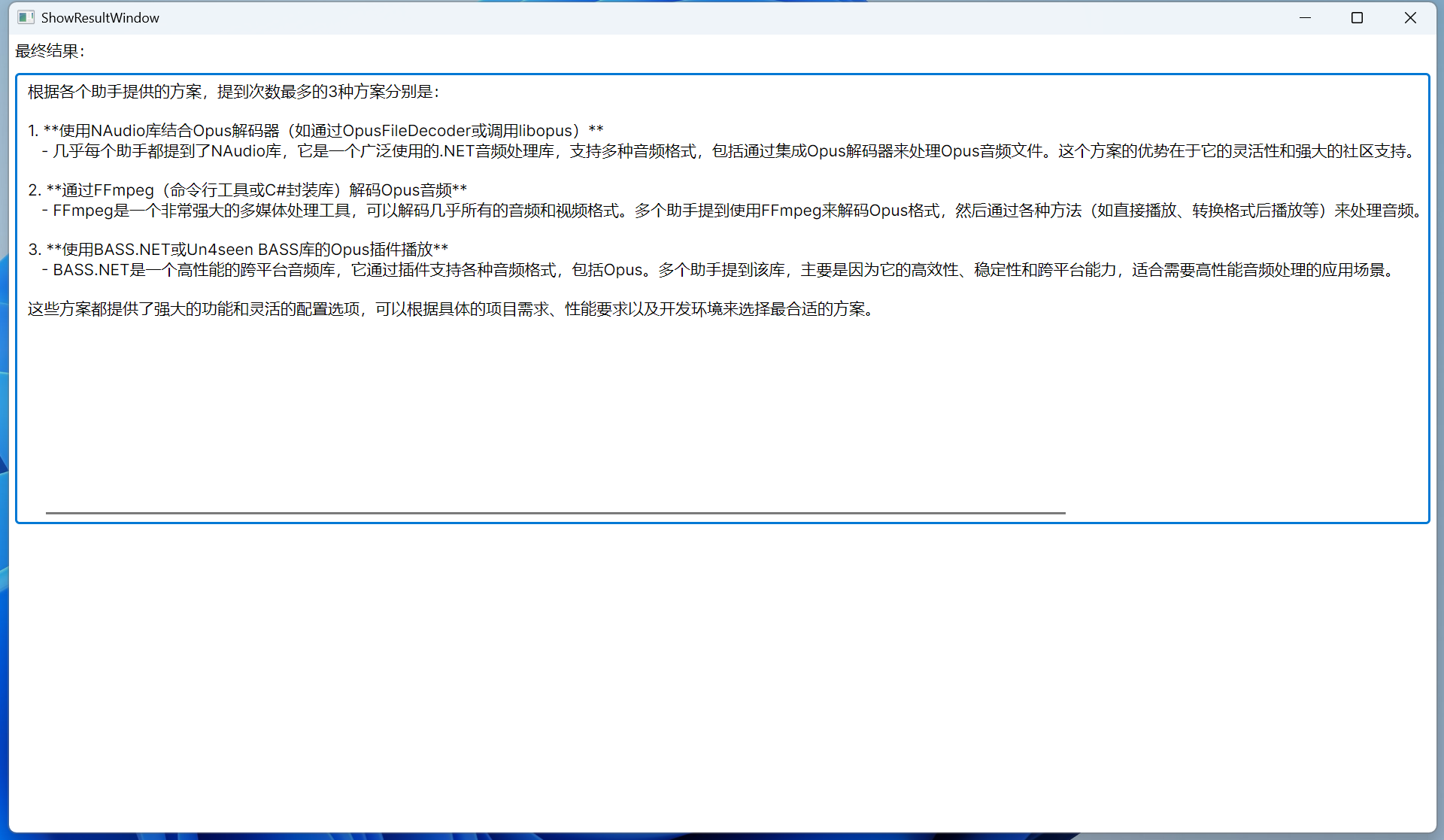

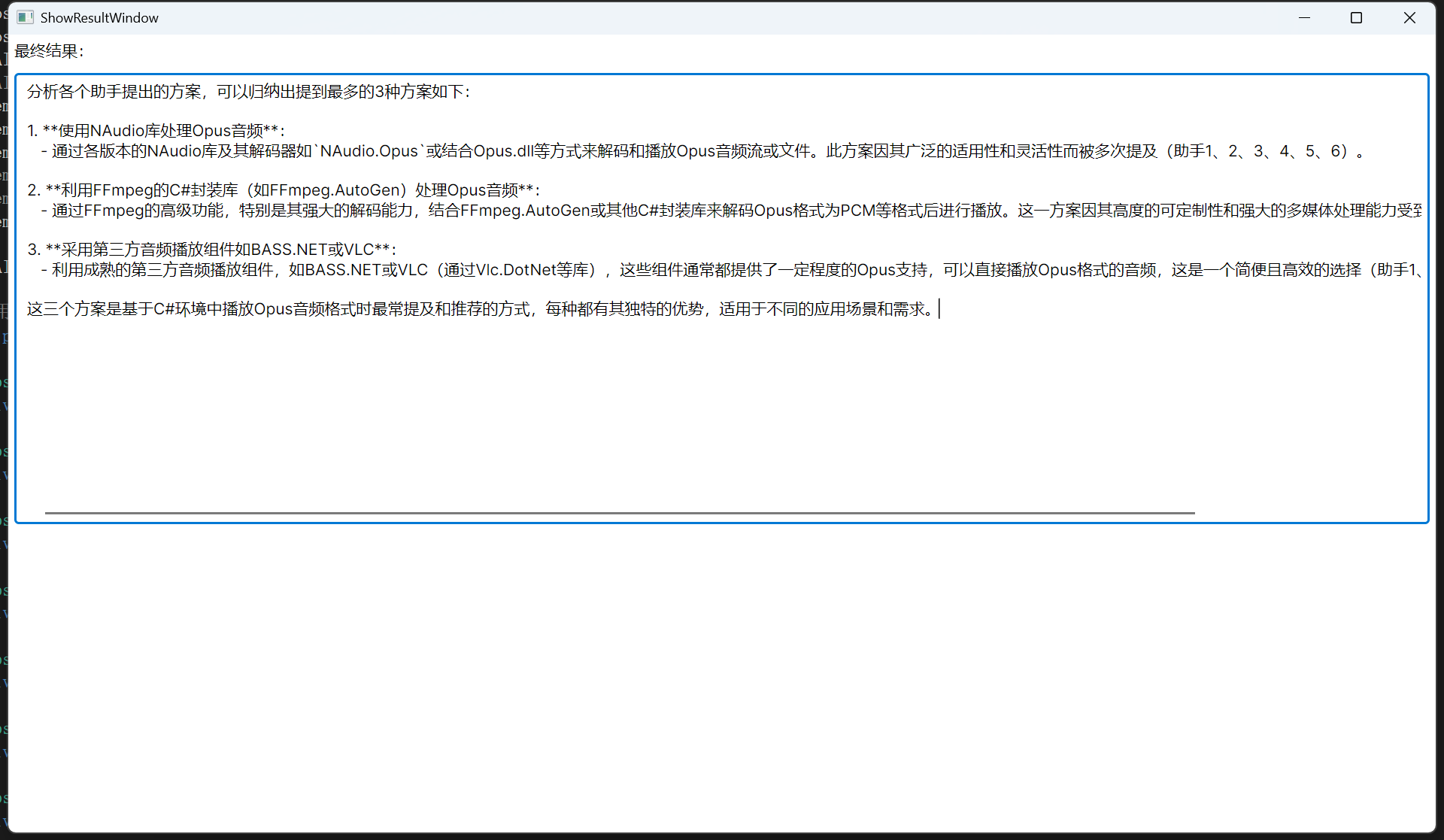

然后总结窗口会显示最终的总结内容:

确定方案之后可以让Cursor或者Cline帮我们写一下试试。

本文来自投稿,不代表本站立场,如若转载,请注明出处:http//www.knowhub.vip/share/2/3166

- 热门的技术博文分享

- 1 . ESP实现Web服务器

- 2 . 从零到一:打造高效的金仓社区 API 集成到 MCP 服务方案

- 3 . 使用C#构建一个同时问多个LLM并总结的小工具

- 4 . .NET 原生驾驭 AI 新基建实战系列Milvus ── 大规模 AI 应用的向量数据库首选

- 5 . 在Avalonia/C#中使用依赖注入过程记录

- 6 . [设计模式/Java] 设计模式之工厂方法模式

- 7 . 5. RabbitMQ 消息队列中 Exchanges(交换机) 的详细说明

- 8 . SQL 中的各种连接 JOIN 的区别总结!

- 9 . JavaScript 中防抖和节流的多种实现方式及应用场景

- 10 . SaltStack 远程命令执行中文乱码问题

- 11 . 推荐10个 DeepSeek 神级提示词,建议搜藏起来使用

- 12 . C#基础:枚举、数组、类型、函数等解析

- 13 . VMware平台的Ubuntu部署完全分布式Hadoop环境

- 14 . C# 多项目打包时如何将项目引用转为包依赖

- 15 . Chrome 135 版本开发者工具(DevTools)更新内容

- 16 . 从零创建npm依赖,只需执行一条命令

- 17 . 关于 Newtonsoft.Json 和 System.Text.Json 混用导致的的序列化不识别的问题

- 18 . 大模型微调实战之训练数据集准备的艺术与科学

- 19 . Windows快速安装MongoDB之Mongo实战

- 20 . 探索 C# 14 新功能:实用特性为编程带来便利

- 相关联分享